![]()

Riconoscimento del modello di un'ala di farfalla. Immagine gentilmente concessa da Li Li

Qui a Washington abbiamo sentito parlare di questa cosa che tu chiami "pianificazione anticipata", ma non siamo ancora pronti ad abbracciarla. Un po 'troppo futuristico.

Tuttavia, non possiamo fare a meno di ammirare da lontano coloro che tentano di prevedere cosa potrebbe accadere tra più di un mese da oggi. Quindi sono stato colpito alcune settimane fa quando i grandi pensatori di IBM hanno immaginato il mondo tra cinque anni e hanno identificato quelle che credono saranno cinque aree di innovazione che avranno il maggiore impatto sulla nostra vita quotidiana.

Lo fanno da alcuni anni ormai, ma questa volta i mossi sfrenati hanno seguito un tema: i cinque sensi umani. Non che stanno dicendo che entro il 2018 saremo tutti in grado di vedere, ascoltare e annusare meglio, ma piuttosto che le macchine lo faranno - che utilizzando tecnologie sensoriali e cognitive in rapida evoluzione, i computer accelereranno la loro trasformazione dal recupero dei dati e elaborare motori per strumenti di pensiero.

Vedi uno schema?

Oggi affrontiamo la visione. È logico supporre che IBM possa riferirsi al Project Glass di Google. Non c'è dubbio che abbia ridefinito il ruolo degli occhiali, dall'accessorio geek che ci aiuta a vedere meglio il combinato smartphone / dispositivo di immersione dati che un giorno indosseremo sui nostri volti.

Ma non è di questo che parlano gli IBM. Sono focalizzati sulla visione artificiale, in particolare sul riconoscimento dei modelli, in base al quale, attraverso la ripetuta esposizione alle immagini, i computer sono in grado di identificare le cose.

A quanto pare, Google è stata coinvolta in uno dei più importanti esperimenti di riconoscimento dei modelli dell'anno scorso, un progetto in cui una rete di 1.000 computer che utilizzavano 16.000 processori è stata, dopo aver esaminato 10 milioni di immagini da video di YouTube, in grado di insegnare a sembrava un gatto.

Ciò che ha reso questo particolarmente impressionante è che i computer sono stati in grado di farlo senza alcuna guida umana su cosa cercare. Tutto l'apprendimento è stato fatto attraverso le macchine che lavoravano insieme per decidere quali caratteristiche dei gatti meritassero la loro attenzione e quali schemi fossero importanti.

E questo è il modello per come le macchine impareranno la visione. Ecco come lo spiega John Smith, senior manager dell'Intelligent Information Management di IBM:

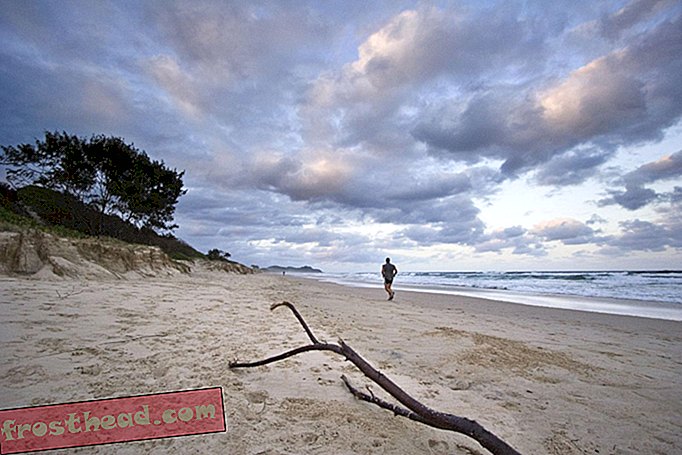

“Diciamo che volevamo insegnare a un computer come appare una spiaggia. Iniziamo mostrando al computer molti esempi di scene sulla spiaggia. Il computer trasformerebbe quelle immagini in caratteristiche distinte, come la distribuzione dei colori, i motivi delle trame, le informazioni sui bordi o le informazioni sul movimento nel caso del video. Quindi, il computer inizierebbe a imparare a discriminare le scene in spiaggia da altre scene in base a queste diverse funzionalità. Ad esempio, apprenderebbe che per una scena da spiaggia si trovano tipicamente determinate distribuzioni di colore, rispetto a un paesaggio urbano del centro. ”

Quanto è intelligente?

Buono per loro. Ma ammettiamolo, identificare una spiaggia è roba piuttosto semplice per la maggior parte di noi umani. Potremmo lasciarci trasportare da quante macchine pensanti saranno in grado di fare per noi?

Gary Marcus, professore di psicologia alla New York University, la pensa così. Scrivendo di recente sul sito web del New Yorker, egli conclude che, sebbene siano stati compiuti molti progressi in quello che è noto come "apprendimento profondo", le macchine hanno ancora molta strada da percorrere prima di essere considerate veramente intelligenti.

“Realisticamente, l'apprendimento profondo è solo una parte della sfida più grande della costruzione di macchine intelligenti. Tali tecniche mancano di modi di rappresentare le relazioni causali (come tra le malattie e i loro sintomi) e sono suscettibili di affrontare sfide nell'acquisizione di idee astratte come "fratello" o "identico a". Non hanno modi ovvi di eseguire inferenze logiche e sono ancora molto lontani dall'integrare la conoscenza astratta, come le informazioni su cosa sono gli oggetti, a cosa servono e come vengono generalmente utilizzati ”.

La gente di IBM lo riconoscerebbe senza dubbio. L'apprendimento automatico avviene a passi, non a passi da gigante.

Ma credono che entro cinque anni, l'apprendimento profondo avrà fatto abbastanza passi avanti che i computer, ad esempio, inizieranno a svolgere un ruolo molto più importante nella diagnosi medica, che potrebbero effettivamente diventare migliori dei medici quando si tratta di individuare tumori, coaguli di sangue o tessuto malato in risonanza magnetica, radiografia o tomografia computerizzata.

E questo potrebbe fare una grande differenza nelle nostre vite.

Vedere per credere

Ecco altri modi in cui la visione artificiale sta avendo un impatto sulla nostra vita:

- Metti il tuo braccio migliore in avanti: la tecnologia sviluppata presso l'Università di Pittsburgh utilizza il riconoscimento di schemi per consentire ai paraplegici di controllare un braccio robotico con il cervello.

- La tua bocca dice di sì, ma il tuo cervello dice di no: i ricercatori di Stanford hanno scoperto che l'uso di algoritmi di riconoscimento dei modelli su scansioni MRI del cervello potrebbe aiutarli a determinare se qualcuno avesse effettivamente il mal di schiena o se lo stessero fingendo.

- Quando le tue talpe sono pronte per i loro primi piani: l' anno scorso una startup rumena di nome SkinVision ha lanciato un'app per iPhone che consente alle persone di scattare una foto delle talpe sulla pelle e quindi avere il software di riconoscimento di SkinVision identificare eventuali irregolarità e indicare il livello di rischio, senza offrendo una diagnosi reale. Il prossimo passo è consentire alle persone di inviare immagini della propria pelle direttamente al proprio dermatologo.

- Ho un accordo per te: ora in fase di sviluppo c'è una tecnologia di marketing chiamata Facedeals. Funziona in questo modo: una volta che una videocamera all'ingresso del negozio ti riconosce, ti vengono inviate offerte in-store personalizzate sul tuo smartphone. E sì, dovresti prima optare.

- Conoscerei quel sigillo ovunque: un sistema computerizzato di identificazione di foto con riconoscimento dei motivi sta aiutando gli scienziati britannici a rintracciare sigilli grigi, che hanno segni unici sui loro cappotti.

Bonus video: mentre siamo in tema di intelligenza artificiale, ecco uno sciame di robot che interpreta Beethoven, complimenti degli scienziati della Georgia Tech. Scommetto che non ti aspettavi di vederlo oggi.

Altro da Smithsonian.com

Un cervello artificiale più umano

Come la tecnologia combatte il terrorismo