L'anno scorso, Facebook ha creato due chatbot e ha chiesto loro di iniziare a parlare tra loro, esercitando le loro capacità di negoziazione. Si scopre che i robot erano abbastanza bravi a negoziare, ma lo hanno fatto usando il loro linguaggio inventato che era incomprensibile per gli umani.

Contenuto relativo

- Questo artista abita nel mondo clandestino di segreti e sorveglianza classificati

Questo è dove il mondo sta andando. I computer stanno creando contenuti l'uno per l'altro, non per noi. Le foto vengono scattate dai computer per essere visualizzate e interpretate da altri computer. Sta succedendo tutto in silenzio, spesso senza la nostra conoscenza o il nostro consenso.

Quindi imparare a vedere come un computer - rendere visibili queste comunicazioni da macchina a macchina - potrebbe essere l'abilità più importante del 21 ° secolo.

Il 25 ottobre 2018, il Kronos Quartet — David Harrington, John Sherba, Hank Dutt e Sunny Yang — ha tenuto un concerto presso lo Smithsonian American Art Museum. Furono osservati da 400 umani e una dozzina di algoritmi di intelligenza artificiale, quest'ultimo per gentile concessione di Trevor Paglen, l'artista dietro la mostra "Sites Unseen", attualmente in mostra al museo.

Mentre i musicisti suonavano, uno schermo sopra di loro mostrava a noi umani cosa vedevano i computer.

Mentre Kronos si faceva strada attraverso un triste pezzo originario dell'Impero ottomano, sullo schermo gli algoritmi sopraelevati rilevavano i volti dei musicisti, delineavano labbra, occhi e naso per ogni persona (e occasionalmente vedevano facce "fantasma" dove non ce n'erano - spesso in La ciocca di capelli del fondatore di Kronos Harrington). Man mano che gli algoritmi diventavano più avanzati, il feed video svanì fino a quando rimasero solo le linee al neon su uno sfondo nero. Alla fine, i contorni del viso svanirono fino a quando una disposizione astratta di linee - presumibilmente tutto il computer necessario per capire la "faccia", ma completamente incomprensibile per gli umani - fu tutto ciò che rimase.

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)

"Sight Machine", Trevor Paglen, Kronos Quartet (Bruce Guthrie)  "Sight Machine", Trevor Paglen, Kronos Quartet

"Sight Machine", Trevor Paglen, Kronos Quartet Il debutto nella East Coast dell'esibizione intitolata "Sight Machine", come l'altro lavoro di Paglen, ha chiesto agli spettatori e agli ascoltatori di imparare a vedere come fanno i computer e di riesaminare il rapporto umano con la tecnologia: i telefoni in tasca e gli occhi in il cielo e tutto il resto.

È il 2018 e l'idea che i telefoni cellulari ci stiano guardando non sembra più una teoria della cospirazione proposta da un blogger nel seminterrato che indossa un cappello di stagnola. Google è stato scoperto all'inizio di quest'anno per monitorare le posizioni degli utenti di telefoni Android, anche se gli utenti hanno disabilitato la funzione. Molte persone sono convinte che i nostri telefoni ci stiano ascoltando per pubblicare meglio gli annunci: Facebook e altre società negano queste accuse, anche se è tecnicamente e legalmente possibile per loro farlo. I giornalisti tecnologici Alex Goldman e PJ Vogt hanno indagato e scoperto la stessa cosa: non c'è motivo per cui i nostri telefoni non stiano ascoltando, ma d'altra parte, gli inserzionisti possono raccogliere informazioni sufficienti su di noi attraverso altri metodi che semplicemente non hanno bisogno di .

È in questo contesto che è stata eseguita "Sight Machine". La dozzina di telecamere che guardano il Kronos Quartet hanno inviato video in diretta dall'esibizione a un rack di computer, che utilizza algoritmi di intelligenza artificiale pronti all'uso per creare immagini inquietanti. Gli algoritmi sono gli stessi utilizzati nei nostri telefoni per aiutarci a scattare selfie migliori, quelli utilizzati dalle auto a guida autonoma per evitare gli ostacoli e quelli utilizzati dalle forze dell'ordine e dalla guida alle armi. Quindi, mentre i risultati sullo schermo erano talvolta belli, o addirittura divertenti, c'era una corrente sotterranea di orrore.

"Ciò che mi stupisce di questo particolare lavoro è che ci sta mostrando qualcosa che è — e questo è vero per tutto il suo lavoro — ci sta mostrando qualcosa che disturba e lo sta facendo usando dei trucchi", afferma John Jacob, il curatore del museo per la fotografia, che ha organizzato "Sites Unseen".

"È un trucco deliberato", dice, "e funziona".

Successivamente, sofisticati algoritmi di riconoscimento facciale hanno formulato giudizi sui membri di Kronos e hanno mostrato i loro risultati su uno schermo. "Questo è John [Sherba]. John ha tra i 24 e i 40 anni", ha detto il computer. "Sunny [Yang] è una donna del 94, 4%. Sunny è arrabbiata all'80% e neutra al 10%."

"Una delle cose che spero che la performance mostri", dice Paglen, "sono alcuni dei modi in cui il tipo di percezione dei computer non è neutrale. È fortemente di parte ... con tutti i tipi di ipotesi politiche e culturali che sono non neutro ". Se il sistema di classificazione di genere afferma che Sunny Yang è una donna del 94, 4 per cento, ciò implica che qualcuno è al 100 per cento. "E chi ha deciso cosa sia una femmina al 100%? Barbie è al 100% femmina? E perché il genere è un binario?" Chiede Paglen. "Vedendo che ciò accade in un momento in cui il governo federale sta cercando di cancellare letteralmente persone di genere queer, è divertente da un lato, ma per me è anche orribile."

Un algoritmo successivo ha rinunciato alle percentuali e si è spostato per identificare semplicemente gli oggetti nella scena. "Microfono. Violino. Persona. Meduse. Parrucca." (Gli ultimi due sono chiaramente errori; l'algoritmo sembra aver confuso Hank Dutt per una medusa e i capelli veri di Harrington per un toupee.) Quindi le classificazioni sono diventate più complesse. "Sunny tiene in mano un paio di forbici" disse la macchina mentre la luce scintillava sulle corde del violoncello. "John tiene in mano un coltello." Cosa accadrebbe se il classificatore fornisse queste informazioni - errate - alle forze dell'ordine, non lo sapremo mai.

La maggior parte degli utenti finali delle piattaforme di intelligenza artificiale, che non sono artisti, potrebbe sostenere che questi sistemi possono avere i loro preconcetti, ma ricevono sempre un consenso finale da parte di un essere umano. Un algoritmo creato da Amazon, Rekognition, che l'azienda vende alle forze dell'ordine e possibilmente all'ICE, ha notoriamente identificato erroneamente 28 membri del Congresso come persone accusate di un crimine confrontando i loro volti con le foto segnaletiche in un database disponibile al pubblico. All'epoca, Amazon sosteneva che l'ACLU, che utilizzava il sistema per creare le partite, aveva usato Rekognition in modo errato. La società ha dichiarato che l'impostazione predefinita del sistema per le partite, chiamata "soglia di confidenza", è solo dell'80%. (In altre parole, l'algoritmo era sicuro solo dell'80% che il rappresentante John Lewis era un criminale.) Un portavoce di Amazon ha affermato che raccomanda ai dipartimenti di polizia di utilizzare una soglia di confidenza del 95% e che "Amazon Rekognition è usato quasi esclusivamente per aiutare restringere il campo e consentire agli umani di rivedere e considerare rapidamente le opzioni usando il loro giudizio. ”I computer potrebbero comunicare tra loro, ma — per ora — stanno ancora chiedendo agli umani di effettuare l'ultima chiamata.

La musica, scelta da Paglen con il contributo di Kronos, ha anche qualcosa da dire sulla tecnologia. Un pezzo, "Powerhouse", di Raymond Scott, è "probabilmente il più famoso per essere utilizzato nei cartoni animati nelle scene di fabbrica", dice Paglen. "Se vedi mai un tipo di fabbrica di sovrapproduzione e impazzire, questa è spesso la musica che parla a questo. Per me è un modo di pensare a quell'industrializzazione quasi da cartone animato e di situarli in un contesto tecnologico." Un altro pezzo, "Different Trains" di Steve Reich, ha chiuso il set. Kronos esegue solo il primo movimento, che riguarda l'infanzia di Reich negli anni '30 e '40; Paglen dice che pensa che il pezzo celebra "un senso di esuberanza e progressi che i treni stanno facilitando". *

È stato accoppiato con le immagini di un database disponibile al pubblico chiamato ImageNet, che vengono utilizzate per insegnare ai computer quali sono le cose. (Chiamato anche "dati di allenamento", quindi sì, è un po 'un gioco di parole.) Lo schermo ha mostrato immagini incredibilmente veloci, mostrando esempi di frutta, fiori, uccelli, cappelli, persone in piedi, persone che camminano, persone che saltano e individui come Arnold Schwarzenegger. Se volessi insegnare a un computer come riconoscere una persona, come Schwarzenegger, o una casa o il concetto di "cena", inizieresti mostrando a un computer queste migliaia di immagini.

C'erano anche brevi videoclip di persone che baciavano, abbracciavano, ridevano e sorridevano. Forse un'intelligenza artificiale addestrata su queste immagini sarebbe benevola e amichevole.

Ma "Different Trains" non riguarda solo l'ottimismo; i movimenti successivi, che Kronos non ha suonato giovedì ma sono "impliciti" dal primo, riguardano il modo in cui la promessa del viaggio in treno è stata appropriata per diventare uno strumento dell'Olocausto. I treni, che sembravano progressi tecnologici, divennero i veicoli in cui decine di migliaia di ebrei furono trasferiti nei campi di sterminio. Quella che sembrava una tecnologia benevola divenne sovvertita per il male.

"È come 'Cosa potrebbe andare storto?" Dice Paglen. "Stiamo raccogliendo tutte le informazioni su tutte le persone del mondo".

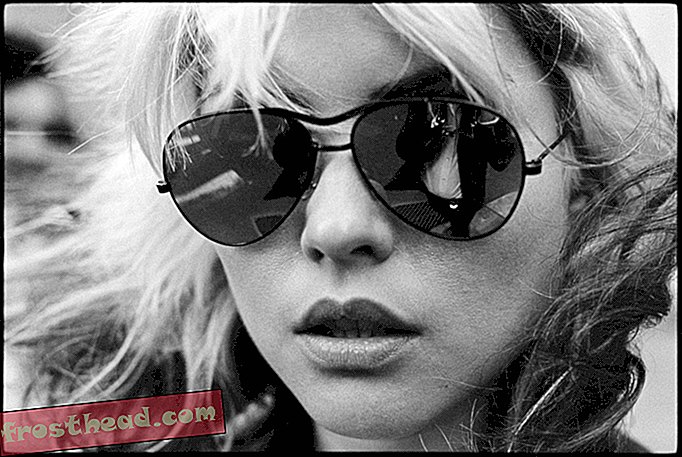

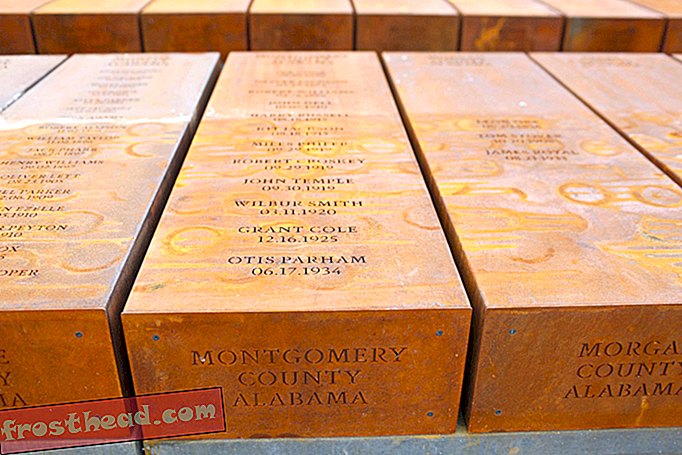

E infatti, alla fine di "Different Trains", l'attenzione si è spostata. Lo schermo non mostrava più immagini di Kronos o dati di allenamento da ImageNet; invece, ha mostrato un feed video dal vivo del pubblico, mentre gli algoritmi di riconoscimento facciale hanno selezionato le caratteristiche di ogni persona. In verità, anche quando pensiamo di non essere osservati, lo siamo.

In un feed video dal vivo del pubblico, gli algoritmi di riconoscimento facciale hanno selezionato le caratteristiche di ogni persona. (Bruce Guthrie)

In un feed video dal vivo del pubblico, gli algoritmi di riconoscimento facciale hanno selezionato le caratteristiche di ogni persona. (Bruce Guthrie) Per raccontare questa storia, ho lasciato la mia casa e sono andato alla stazione della metropolitana, dove ho scannerizzato una scheda elettronica collegata al mio nome per passare attraverso il tornello, e di nuovo quando ho lasciato la metropolitana in centro. In centro, ho superato una mezza dozzina di telecamere di sicurezza prima di entrare nel museo, dove ne ho individuate almeno altre due (un portavoce della Smithsonian afferma che la Smithsonian non usa la tecnologia di riconoscimento facciale; il dipartimento di polizia metropolitana DC dice lo stesso delle sue telecamere).

Ho registrato interviste utilizzando il mio telefono e caricato l'audio su un servizio di trascrizione che utilizza l'IA per capire cosa sto dicendo io e i miei soggetti e che potrei o meno indirizzare la pubblicità verso di me in base al contenuto delle interviste. Ho inviato e-mail utilizzando Gmail, che "legge" ancora tutto ciò che invio (anche se non è più per pubblicarmi).

Durante il processo di segnalazione, mentre camminavo per la città, mi sono imbattuto nell'auto di Google Street View, non me la sto inventando. Due volte. Non è paranoia se ti stanno davvero guardando, vero?

Quindi cosa rimane, in questo mondo in cui i computer stanno facendo il punto di vista e forse stanno dando giudizi su di noi? "Sight Machine" ci spinge ad imparare a pensare come un computer, ma ci ricorda anche che ci sono alcune parti di noi che, per ora, sono ancora completamente umane.

La musica, dice Paglen, "è qualcosa che in realtà non è quantificabile ... quando guardi un sistema di visione artificiale essenzialmente interrogare gli artisti, in realtà per me sottolinea quel vasto abisso nelle percezioni tra il modo in cui percepiamo la cultura, le emozioni e il significato. e tutti i modi in cui quelli sono invisibili ai sistemi autonomi ".

O come dice Harrington, puoi fare musica con un violino in legno o uno realizzato con una stampante 3D. Puoi usare un arco in fibra di carbonio o uno in legno di pernambuco. Ma, dice, l'arco deve ancora essere tirato attraverso le corde. La musica "diventa più preziosa perché è fatta a mano".

E per ora, è ancora qualcosa che solo noi possiamo fare. Le macchine potrebbero non aver più bisogno di noi. Ma quando si tratta del suono solenne di un arco su una corda di violino e delle corde emotive che notano i rimorchiatori, non abbiamo bisogno delle macchine.

"Trevor Paglen: Sites Unseen", a cura di John Jacob, continua allo Smithsonian American Art Museum a Washington, DC, fino al 6 gennaio 2019. Si prevede che viaggerà al San Diego Museum of Contemporary Art dal 21 febbraio al 2 giugno, 2019.

* Nota del redattore, 2 novembre 2018: questa storia è stata modificata per chiarire il significato previsto e la storia di origine della composizione "Diversi treni" di Steve Reich.