![]()

Analisi facciale al lavoro. Immagine gentilmente concessa da Affectiva

Quanto tempo trascorriamo con i nostri telefoni cellulari, laptop e tablet, è ancora praticamente una relazione a senso unico. Agiamo, loro rispondono. Certo, puoi continuare una conversazione con Siri sul tuo iPhone, e mentre è veloce, difficilmente si qualifica come battute giocose. Fai domande, lei dà risposte.

E se questi dispositivi potessero davvero leggere le nostre emozioni? E se potessero interpretare ogni piccolo gesto, ogni indizio facciale in modo da poter misurare i nostri sentimenti e, forse meglio dei nostri migliori amici? E poi rispondono, non con informazioni, ma cosa potrebbe passare per empatia.

Non ci siamo ancora arrivati, ma ci stiamo muovendo rapidamente in quella direzione, spinti da un campo scientifico noto come il calcolo affettivo. È costruito attorno a software in grado di misurare, interpretare e reagire ai sentimenti umani. Ciò potrebbe comportare l'acquisizione del viso sulla fotocamera e l'applicazione di algoritmi ad ogni aspetto delle espressioni per cercare di dare un senso a ogni sorriso e sfregamento del mento. Oppure potrebbe comportare la lettura del tuo livello di fastidio o piacere monitorando la velocità o con quanta forza tocchi un testo o se usi le emoticon. E se sembri troppo agitato o ubriaco, potresti ricevere un messaggio che suggerisce che potresti voler tenere premuto premendo l'icona di invio.

Vedendo quanto è difficile per noi umani dare un senso agli altri umani, questa nozione di macchine di programmazione per leggere i nostri sentimenti non è una piccola sfida. Ma sta prendendo velocità, mentre gli scienziati acuiscono la loro attenzione sull'insegnamento dell'intelligenza emotiva dei dispositivi.

Ogni mossa che fai

Uno dei migliori esempi di come il calcolo affettivo può funzionare è l'approccio di un'azienda chiamata, in modo appropriato, Affectiva. Registra le espressioni e poi, usando algoritmi proprietari, esamina scrupolosamente i segnali del viso, attingendo a un database di quasi 300 milioni di fotogrammi di elementi di volti umani. Il software è stato perfezionato al punto da poter associare varie combinazioni di quegli elementi a differenti emozioni.

Quando è stato sviluppato presso il Media Lab del MIT da due scienziati, Rosalind Picard e Rana el Kaliouby, il software, noto come Affdex, è stato progettato allo scopo di aiutare i bambini autistici a comunicare meglio. Ma chiaramente aveva un sacco di potenziale nel mondo degli affari, e quindi il MIT ha trasformato il progetto in una società privata. Da allora ha raccolto $ 21 milioni dagli investitori.

Quindi, come viene utilizzato Affdex? Molto spesso, sta guardando gente che guarda spot pubblicitari. registra le persone mentre visualizzano gli annunci sui loro computer - non preoccuparti, devi optare per questo - e quindi, in base al suo database di segnali facciali, valuta come gli spettatori sentono ciò che hanno visto. E il software non fornisce solo un giudizio complessivo positivo o negativo; scompone le reazioni degli spettatori secondo per secondo, il che consente agli inserzionisti di identificare, con più precisione che mai, ciò che funziona in uno spot e cosa no.

È anche in grado di vedere che mentre le persone dicono una cosa, i loro volti possono dire un'altra. Durante un'intervista con l'Huffington Post, el Kaliouby ha fornito l'esempio della risposta a una pubblicità per la lozione per il corpo trasmessa in India. Durante la pubblicità, un marito tocca scherzosamente lo stomaco esposto della moglie. Successivamente, un certo numero di donne che l'hanno visto hanno affermato di aver trovato quella scena offensiva. Ma, secondo El Kaliouby, i video degli spettatori hanno mostrato che ognuna delle donne ha risposto alla scena con quello che ha definito un "sorriso di godimento".

Vede opportunità oltre il mondo della pubblicità. Le Smart TV potrebbero essere molto più intelligenti su che tipo di programmi ci piacciono se sono in grado di sviluppare un banco di memoria delle nostre espressioni facciali. E i politici sarebbero in grado di ottenere reazioni in tempo reale su ogni linea pronunciata durante un dibattito e di poter adattare i loro messaggi al volo. Inoltre, dice el Kaliouby, potrebbero esserci applicazioni sanitarie. Dice che è possibile leggere la frequenza cardiaca di una persona con una webcam analizzando il flusso sanguigno in faccia.

"Immagina di avere sempre una videocamera accesa per monitorare la frequenza cardiaca", ha detto all'Huffington Post, "in modo che possa dirti se qualcosa non va, se hai bisogno di essere più in forma, o se stai corrugando la fronte per tutto tempo e necessità di rilassarsi. "

Cosa ne pensi, inquietante o figo?

Dispositivi di localizzazione

Ecco altri cinque modi in cui le macchine reagiscono alle emozioni umane:

- E com'è andata la mia giornata? I ricercatori dell'Università di Cambridge hanno sviluppato un'app mobile Android che monitora il comportamento di una persona durante il giorno, utilizzando chiamate e messaggi in arrivo, oltre a post sui social media per tracciare il loro umore. L'app, chiamata "Emotion Sense", è progettata per creare un "viaggio alla scoperta", che consente agli utenti di avere una registrazione digitale delle vette e delle valli della loro vita quotidiana. I dati possono essere memorizzati e utilizzati per sessioni di terapia.

- E questo sono io dopo la terza tazza di caffè: poi c'è Xpression, un'altra app di monitoraggio dell'umore creata da una società britannica chiamata EI Technologies. Invece di fare affidamento sulle persone in terapia per mantenere i diari dei loro cambiamenti di umore, l'app ascolta i cambiamenti nella voce di una persona per determinare se si trovano in uno dei cinque stati emotivi: calma, felice, triste, arrabbiata o ansiosa / spaventata. Tiene quindi un elenco degli stati d'animo di una persona e quando cambiano. E, se la persona lo desidera, questo record può essere automaticamente inviato a un terapeuta alla fine di ogni giorno.

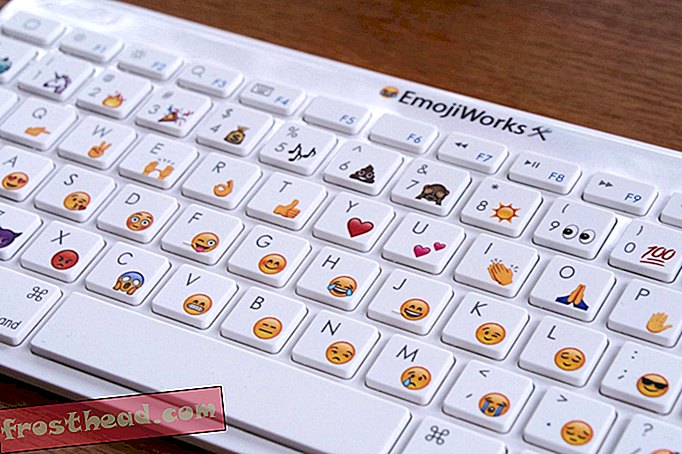

- E se odiassi scrivere sul telefono? : Gli scienziati Samsung stanno lavorando a un software che misurerà il tuo stato d'animo in base a come digiti i tuoi tweet sul tuo smartphone. Analizzando la velocità di digitazione, la frequenza di vibrazione del telefono, la frequenza degli errori di backspace e il numero di emoticon utilizzate, il telefono dovrebbe essere in grado di determinare se sei arrabbiato, sorpreso, felice, triste, impaurito o disgustato. E in base a quale conclusione trae, potrebbe includere nel tuo tweet l'emoticon appropriata per dare la mancia ai tuoi seguaci al tuo stato d'animo.

- Basta non invitare i tuoi amici a guardare: utilizzando un sensore indossato al polso e una fotocamera per smartphone indossata intorno al collo, i ricercatori del MIT hanno creato un sistema di “salvataggio in vita” che raccoglie immagini e dati progettati per mostrare a una persona quali eventi rappresentavano i loro alti e bassi emotivi. Il sistema, chiamato Inside-Out, include un bio-sensore in un cinturino che traccia le emozioni accentuate attraverso le cariche elettriche nella pelle mentre lo smartphone traccia la posizione della persona e scatta diverse foto al minuto. Quindi, alla fine della giornata, l'utente può visualizzare le proprie esperienze, insieme a tutti i dati del sensore.

- La tua fronte dice che hai problemi: questo probabilmente era inevitabile. I ricercatori dell'Università della California del Sud hanno creato un terapista robotico che non solo è programmato per incoraggiare i pazienti con "Uh-huhs" tempestivo, ma è anche esperto, utilizzando sensori di movimento e analisi della voce, per interpretare ogni gesto e voce di un paziente inflessione durante una sessione di terapia.

Bonus video: vuoi vedere quanto può diventare bizzarra questa tendenza dei dispositivi che leggono le emozioni umane? Dai un'occhiata a questa promozione di Tailly, una coda meccanica che aumenta il tuo livello di eccitazione monitorando il battito cardiaco e agitando opportunamente.

Altro da Smithsonian.com

Questo nuovo robot ha un senso del tatto

Cucinare Con I Robot