Girare una scena in un film può richiedere dozzine di riprese, a volte di più. In Gone Girl, si diceva che il regista David Fincher avesse in media 50 riprese per scena. Per gli attori di The Social Network Rooney Mara e Jesse Eisenberg hanno recitato la scena di apertura 99 volte (diretto di nuovo da Fincher; a quanto pare è noto per questo). The Shining di Stanley Kubrick ha coinvolto 127 riprese della famigerata scena in cui Wendy indietreggia su per le scale facendo oscillare una mazza da baseball a Jack, ampiamente considerata la più presa per scena di qualsiasi film della storia.

Un nuovo software, della Disney Research in collaborazione con l'Università del Surrey, può aiutare a ridurre il numero di riprese necessarie, risparmiando così tempo e denaro. FaceDirector fonde immagini di diverse riprese, rendendo possibile la modifica di emozioni precise sui volti degli attori.

"La produzione di un film può essere molto costosa, quindi l'obiettivo di questo progetto era quello di cercare di rendere il processo più efficiente", afferma Derek Bradley, uno scienziato informatico della Disney Research di Zurigo che ha contribuito allo sviluppo del software.

Disney Research è un gruppo internazionale di laboratori di ricerca focalizzati sui tipi di innovazione che potrebbero essere utili a Disney, con sedi a Los Angeles, Pittsburgh, Boston e Zurigo. I progetti recenti includono un robot da arrampicata su parete, un "libro da colorare in realtà aumentata" in cui i bambini possono colorare un'immagine che diventa un personaggio in movimento 3D su un'app e un giubbotto per bambini che fornisce sensazioni come vibrazioni o la sensazione di gocce di pioggia con cui corrispondere scene del libro di fiabe. Il team dietro FaceDirector ha lavorato al progetto per circa un anno, prima di presentare le loro ricerche alla Conferenza internazionale sulla visione artificiale a Santiago, in Cile, lo scorso dicembre.

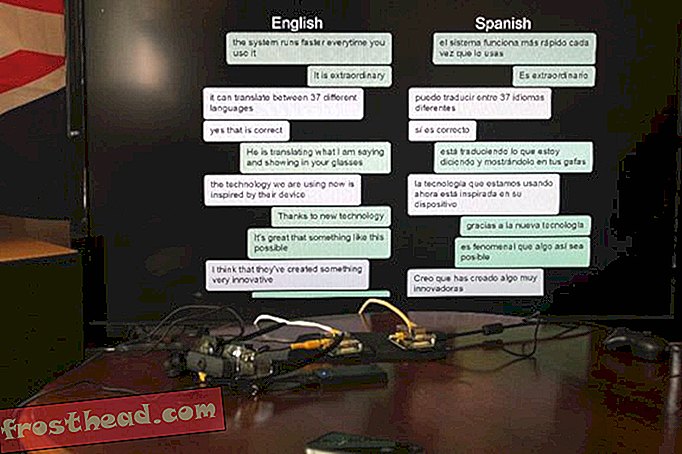

Capire come sincronizzare diverse riprese è stato l'obiettivo principale del progetto e la sua più grande sfida. Gli attori potrebbero avere la testa inclinata a diverse angolazioni da prendere a prendere, parlare con toni diversi o mettere in pausa in momenti diversi. Per risolvere questo problema, il team ha creato un programma che analizza le espressioni facciali e i segnali audio. Le espressioni facciali vengono tracciate mappando i punti di riferimento del viso, come gli angoli degli occhi e della bocca. Il programma determina quindi quali fotogrammi possono essere adattati l'uno all'altro, come i pezzi del puzzle. Ogni pezzo del puzzle ha più compagni, quindi un regista o un editore può quindi decidere la combinazione migliore per creare l'espressione facciale desiderata.

Per creare materiale con cui sperimentare, il team ha riunito un gruppo di studenti dell'Università delle Arti di Zurigo. Gli studenti hanno recitato in diverse fasi di un dialogo inventato, ogni volta facendo diverse espressioni facciali: felici, arrabbiati, eccitati e così via. Il team è stato quindi in grado di utilizzare il software per creare un numero qualsiasi di combinazioni di espressioni facciali che trasmettessero emozioni più sfumate: tristi e un po 'arrabbiate, eccitate ma timorose e così via. Sono stati in grado di fondere diverse riprese - diciamo, spaventate e neutrali - per creare emozioni in aumento e in diminuzione.

Il team di FaceDirector non è sicuro di come o quando il software potrebbe essere disponibile in commercio. Il prodotto funziona ancora meglio se utilizzato con scene riprese mentre è seduto di fronte a uno sfondo statico. Gli attori in movimento e lo scenario all'aperto in movimento (pensa a alberi ondeggianti, macchine che passano) rappresentano una sfida per la sincronizzazione.